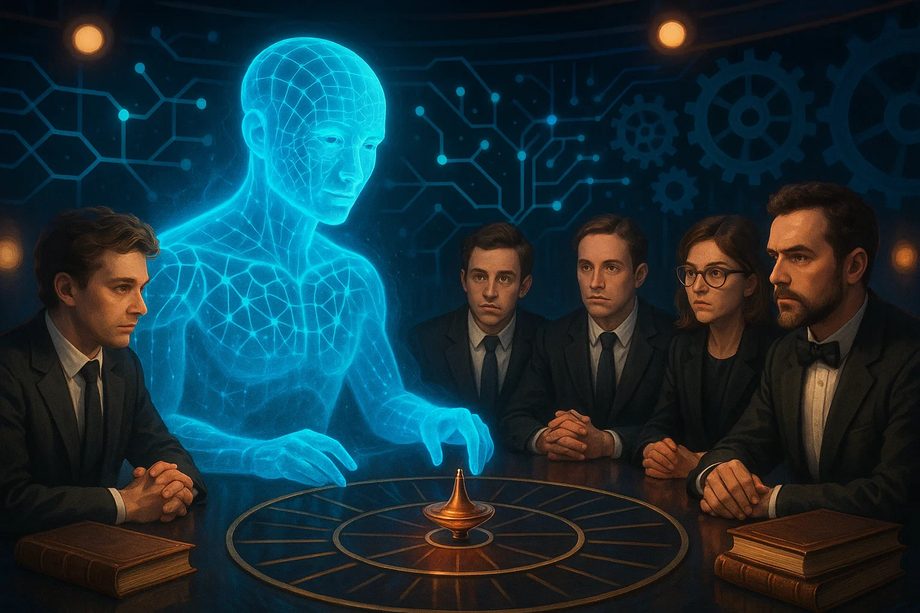

Investigadores de la Universidad Federal del Sur (SFU) propusieron una forma inusual de evaluar el nivel de desarrollo de la inteligencia artificial: hacer que responda preguntas de los concursos de televisión "¿Qué? ¿Dónde? ¿Cuándo?" y "Su propio juego". Resultó que incluso los modelos de lenguaje más avanzados (LLM) hacen frente a tales tareas peor que el ruso medio.

El principal problema de los LLM modernos, incluidos ChatGPT y LLaMa-3, es la falta de datos de calidad en ruso. Como explicó Bogdan Protsenko, jefe del proyecto en la SFU, los modelos extranjeros a menudo se entrenan con conjuntos de datos en inglés, y el contenido en ruso se traduce o se presenta en un volumen menor.

En los datos para el preentrenamiento de todos los modelos extranjeros hay notablemente menos ruso que inglés, por lo que el modelo escribe y piensa de forma más "inteligente" y competente si se le pregunta en inglés y se le pide que responda en él. Los benchmarks, las "líneas" con las que se mide la calidad de los modelos y su funcionamiento en diferentes idiomas, suelen ser simplemente una traducción de uno de los idiomas, normalmente el inglés, a otros. Esta situación no refleja la calidad del trabajo del modelo en una situación lingüística real.

Las preguntas de "¿Qué? ¿Dónde? ¿Cuándo?" requieren no solo erudición, sino también comprensión del contexto cultural, juegos de palabras y conexiones lógicas. La LLM, que tiene 405 mil millones de parámetros y es capaz de comprender decenas de lenguajes naturales y lenguajes de programación, así como de entender una amplia gama de campos del conocimiento, desde la mecánica cuántica hasta la medicina, cometió errores en preguntas sobre el compositor Vladimir Shainsky o el Zar-cañón, temas obvios para los rusohablantes.

Mikhail Levandovsky, cuatro veces campeón mundial del juego "¿Qué? ¿Dónde? ¿Cuándo?", señaló que la principal característica de este juego es su variabilidad. Al comienzo de la historia del juego "¿Qué? ¿Dónde? ¿Cuándo?", la clave del éxito era la capacidad de reconocer "fenómenos": imágenes abstractas y patrones sociales. Para los sistemas modernos de inteligencia artificial, esto sigue siendo un problema grave.

Los científicos experimentaron con diferentes métodos de generación de respuestas, incluida la "cadena de razonamiento" y la autocrítica interna del modelo. Resultó que el enfoque que imita la discusión en un equipo de expertos mejora la precisión, pero a veces suprime la creatividad de la IA.

Definitivamente será más fácil para la inteligencia artificial resolver las preguntas de "Su propio juego", ya que generalmente están dirigidas a la erudición y el conocimiento personal del jugador, mientras que las preguntas de "¿Qué? ¿Dónde? ¿Cuándo?" están más bien dirigidas a la capacidad del equipo de expertos para pensar y adivinar. Para responder a una pregunta promedio de "¿Qué? ¿Dónde? ¿Cuándo?", un ruso generalmente no necesita ningún conocimiento especial más allá del programa escolar y la cultura general, otra cosa es que a menudo las preguntas están "envueltas" de tal manera que solo unos pocos entenderán de qué se trata. Si la comunidad de autores de preguntas de "¿Qué? ¿Dónde? ¿Cuándo?" descubre que la IA ha aprendido a responder a sus preguntas con facilidad, esto los motivará a complicar nuevas preguntas de tal manera que la IA no tenga ninguna posibilidad, mientras que para los expertos la dificultad seguirá siendo la misma.

La inteligencia artificial (IA) aún no puede compararse con el ser humano en la capacidad de generar nuevas ideas y encontrar soluciones no estándar. Aunque la IA puede responder a preguntas para las que ya existe una respuesta correcta, todavía no es capaz de pensar creativamente y crear algo nuevo. Hasta que los grandes modelos de lenguaje no se entrenen con datos en ruso, nos superarán incluso en los concursos.

Lea también materiales sobre el tema:

La empresa "High-Tech" presentó un acelerador de IA ruso con un rendimiento récord de 960 TOPS

Científicos rusos han creado un sistema de IA para monitorear la fatiga

Académico de la Academia de Ciencias de Rusia: Rusia debe centrarse en modelos de IA aplicados